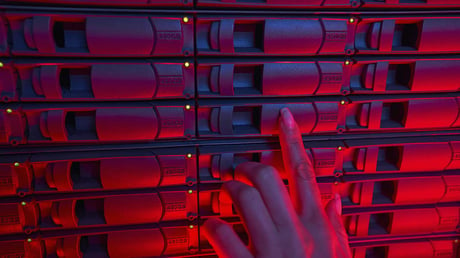

Una soluzione di Data Center è un insieme di hardware, software e servizi progettati per elaborare, gestire, archiviare e distribuire grandi quantità di dati. In genere comprende una vasta gamma di componenti, tra cui server, storage, reti, software, sicurezza, controllo accessi, raffreddamento e alimentazione elettrica. Sia essa un'infrastruttura fisica o virtuale, basata cioè sul cloud, una soluzione di Data Center offre altresì una serie di servizi integrati e personalizzabili per supportare le esigenze specifiche dell'organizzazione.

I criteri per confrontare le soluzioni di Data Center sul mercato

Confrontare la pletora di soluzioni disponibili non è un compito agevole, soprattutto per il numero di fattori da considerare. Il mercato inoltre presenta un’ampia offerta di fornitori, ognuno dei quali con una propria gamma di soluzioni e servizi. Alcuni dei criteri più diffusi di comparazione sono scalabilità, affidabilità, sicurezza, supporto, costo, infrastruttura, ma ogni raffronto nella scelta della soluzione migliore richiede una comprensione approfondita delle tecnologie e delle opzioni disponibili e deve sempre tenere conto delle esigenze specifiche dell'organizzazione.

Scalabilità. Facciamo un esempio. In genere quando si parla di scalabilità si fa riferimento alla capacità di espandere o ridurre la capacità di elaborazione, archiviazione, rete e connettività di un'infrastruttura IT in modo rapido ed efficiente per adattarsi alle esigenze aziendali. Una soluzione scalabile è quindi in grado di crescere o ridimensionarsi – in termini di numero di server, spazi di archiviazione, larghezza di banda o servizi di connettività di rete - senza compromettere l'affidabilità e le prestazioni dei servizi forniti.

La scalabilità è un fattore importante da considerare perché da essa dipende buona parte delle capacità dell’azienda di affrontare i picchi di traffico, supportare la crescita aziendale e i cambiamenti nelle esigenze dei clienti in modo flessibile ed efficiente. Più nel dettaglio, le soluzioni di Data Center per garantire una scalabilità efficace devono avere una serie di caratteristiche a partire da una infrastruttura flessibile che consenta alle aziende di espandere o ridurre la capacità di elaborazione, archiviazione, rete e connettività in base alle esigenze. La flessibilità oggi è un concetto associato sempre più spesso all’automazione delle attività ripetitive, all'orchestrazione - la capacità di gestire le risorse in modo centralizzato e coordinato - e all'agilità dell’infrastruttura di adattarsi rapidamente alle richieste delle aziende. Ultimo ma non ultimo elemento da valutare è la sicurezza, fondamentale per proteggere i dati durante le operazioni di scalabilità dell'infrastruttura IT.

La scalabilità può essere misurata in diversi modi, ma di solito le tre metriche a cui si fa riferimento sono la scalabilità verticale e orizzontale e l’elasticità.

La scalabilità verticale è la capacità di aumentare le risorse di elaborazione di un singolo nodo del sistema, ad esempio aumentando la capacità di elaborazione della CPU, la quantità di memoria RAM disponibile o l'utilizzo di unità di elaborazione grafica (GPU). L’importanza di questa metrica si apprezza soprattutto nelle situazioni in cui a fronte di un aumento sostanziale del carico di lavoro il sistema non può gestire la domanda aggiuntiva utilizzando le risorse hardware esistenti. Invece di aggiungere ulteriori nodi al sistema, è possibile aumentare le risorse di elaborazione del singolo nodo per gestire il carico di lavoro in modo più efficiente. Esiste tuttavia un limite alla scalabilità verticale, in quanto le risorse hardware possono diventare troppo costose o tecnicamente inadeguate per gestire il carico di lavoro richiesto. In questo caso è necessario considerare la scalabilità orizzontale, ovvero l'aggiunta di ulteriori nodi al sistema - server, istanze di un'applicazione, etc. - per distribuire i carichi di lavoro e aumentare la capacità complessiva di elaborazione. La scalabilità orizzontale, particolarmente importante in situazioni in cui le risorse hardware esistenti non riescono a gestire in modo efficiente le sollecitazioni provenienti dalla domanda aggiuntiva, è molto utilizzata in ambienti cloud, dove la possibilità di utilizzare risorse on-demand virtualmente non conosce limiti.

La terza metrica da considerare è l'elasticità (o scalabilità elastica) ovvero la capacità di un sistema di gestire un aumento di carico in modo automatico e dinamico così da assicurare prestazioni ottimali e disponibilità continua. Particolarmente importante nel caso di applicazioni web o mobile, soggette a picchi di traffico improvvisi e fluttuazioni della domanda in base all'orario o alla stagione, l'elasticità a sua volta può essere misurata utilizzando metriche come il tempo di risposta del sistema, l’utilizzo della CPU, il throughput - cioè la quantità di dati elaborati nell'unità di tempo - e la percentuale di utilizzo delle risorse disponibili.

Infine, la valutazione stessa dell’infrastruttura del Data Center è fondamentale: primi tra tutti i fattori, alimentazione elettrica e condizionamento fanno la differenza nella continuità del servizio, garantendo affidabilità in qualsiasi situazione e di fronte a qualsiasi evento inatteso.

in particolare, il sistema di alimentazione elettrica deve essere ridondante e includere UPS (Uninterruptible Power Supply) e generatori di emergenza per garantire continuità del servizio in caso di emergenze.

Per quanto riguarda il condizionamento, deve essere affidabile per dissipare il calore prodotto dai server e dagli altri dispositivi. L'uso di sistemi di raffreddamento ad alta efficienza energetica, come l'aria fredda esterna o il raffreddamento a liquido, può contribuire a ridurre i costi operativi e l'impatto ambientale.

In generale l’obiettivo è evitare i cosiddetti "single point of failure" (SPOF), ovvero punti critici nell'infrastruttura che, se guasti, possono causare interruzioni del servizio.

Data Center: scegliere consapevolmente

Per una corretta misurazione della scalabilità di un'infrastruttura IT è importante prendere in considerazione tutti questi aspetti, poiché ciascuno incide sulla capacità di gestione dei picchi di traffico e dei carichi di lavoro imprevisti. Analoga importanza riveste l’utilizzo di strumenti di monitoraggio e analisi continue delle prestazioni dell'infrastruttura IT, utili per identificare tempestivamente l’insorgenza di eventuali problemi.